Abstract

Multimodal sentiment analysis(이하 msa)는 language, visual, acoustic modalities를 활용해서 sentiment를 연구하는 분야다.

msa의 중요한 문제는 이러한 modalities에서 정보를 처리하는 joint representation을 추론하는 것이다.

- 그러나 지금까지의 연구는 이 joint representation을 얻기 위해서 모든 modalities가 input, result로 존재해야 했다.

- test time에서 noisy나 missing에 민감햇다.

seq2seq가 기계번역 부분에서 성공을 거둔 것을 바탕으로 test time에서 모든 input modalities가 필요하지 않을 새로운 방법을 생각했다.

- 이번 논문에서 modalities간에 번역을 함으로써 joint representation을 배우는 방법에 대해서 소개한다.

이 방법은 source에서 target으로 번역을 해서 joint representation을 배우지만 source modalities만 input으로 필요하다는 것이 key point이다.

- cycle consistency loss를 사용한다.

- train 과정에서는 paired multimodal data가 필요하지만 test 과정에서는 source 만 있어도 된다.

항상 당연한 거지만 좋은 성능을 거두었다고 한다.

Introduction

text만 있던 sentiment analysis는 불충분한 면이 있었다. 그래서 최근에는 visual이나 acoustic같은 추가적인 정보를 사용해서 joint representation을 학습하고 있다.

위에서 말했던 것처럼 기존의 multimodal 방법들은 test time에도 모든 modalities가 필요했고, 이는 noisy나 missing modalities에 민감했다.

이 문제를 풀기 위해서 Seq2Seq의 최근 성공에서 영감을 받았다. 그래서 modalities 간에 번역을 함으로써 robust joint multimodal representation을 배우기 위해서 Multimodal Cyclic Translation Network model을 제안한다.

source modality에서 target modality로 번역하는 것이 intermediate representation을 얻을 수 있고, forward translations와 backward translation을 하는 cyclic translation loss를 사용한다.

또한 이를 계층적으로 쌓아서 두 개의 modalities에서 세 개로 확장할 수 있다. MCTN의 다른 장점은 test 과정에서 source modality만 필요하다는 것이다. 그 결과로 robust한 특징을 가지게 된다.

Related Work

생략

Proposed Approach

Learning Joint Representation

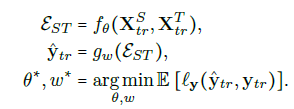

XS 와 XT 사이에 Joint Representation은 εST=fθ(XS ,XT) embedding을 반환하는 parametrized function fθ로 정의된다. 그리고 다른 함수인 gw는 joint representation으로 label을 예측하는 함수다.

Train 과정에서는 θ 와 w가 다음과 같은 empirical risk minimization으로 학습된다.

Test 과정에서는

Multimodal Cyclic Translation Network

MCTN은 modality 번역으로 robust joint representation을 학습하는 neural model이다.

source 에서 target으로의 번역이 XS 와 XT 사이의 joint information을 포착하는 intermediate representation을 만들어 낸다.

모든 modalities로 부터 maximal information를 가지는 joint representation을 배우도록 하기 위해 cycle consistency loss를 사용한다. 그리고 informative joint representations를 배우면서 input으로 source만 필요하도록 multimodal environment에서 back-translation를 사용한다. cycle consistency loss는 함수 fθ를 encoder와 decoder 부분으로 decomposing 함으로써 시작한다.

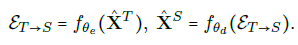

source 를 기준으로 보면 encoder는 다음과 같고,

decoder는 다음과 같다.

target으로 translated back을 하면 다음과 같다.

일반적으로 기계번역에서 사용하는 Seq2Seq를 multimodal 에서 사용하는 것이다.

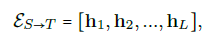

encoder의 output은 다음과 같다.

decoder는 representation에서 target modality로 map 한다.

MCTN은 다음과 같은 식으로 best translation을 구한다.

test 과정에서 target modality에 대한 의존성을 제거하기 위해 forward translated representation을 추론에서 사용했다.

Coupled Translation - Prediction Objective

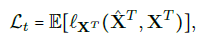

forward translation loss

cycle consistency loss

prediction loss

total loss

hyperparameter들은 이 total loss를 최소화하여 학습한다.

Hierarchical MCTN for Three Modalities

지금까지는 biomodal 이었던 것을 계층적인 구조로 확장해본다. XS에서 XT1,XT2로 넘어가도록 만드는 것이며, 처음에는 XS에서 XT1으로 번역하는 representation을 만들고, 두번째 단계에서는 여기서 얻은 representation에서 XT2로 번역을 한다. 그림으로 보면 다음과 같다.

Experimental Setup

Dataset and Input Modalities

CMU-MOSI, ICT-MMMO, YouTube를 사용했다.

Multimodal Features and Alignment

Glove, Facet, COVAREP를 각 language, visual, acoustic 특징을 뽑아내는데에 사용했다.

Evaluation Metrics

CMU-MOSI에서는 MAE loss function을 사용했고, Acc, F1를 구했다.

ICT-MMMO, YouTube에서는 categorical cross-entropy를 사용했고, F1를 구했다.

공통적으로 MAE와 Corr을 계산했다.

Baseline Models

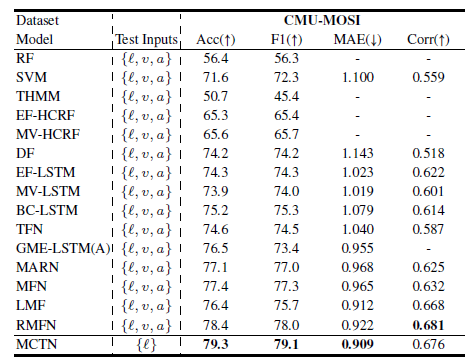

RMFN, LMF, TFN, MFN, EF-LSTM등과 비교해보았다.

Results and Discussion

Comparison with Existing Work

이번 논문에서 제안한 방법이 가장 성능이 좋았다. 게다가 다른 모델들은 모든 modal이 필요했는데, 이 모델은 language 하나만으로 test한 결과다.

Adding More Modalities

위 실험결과를 보면 bimodal보다 Trimodal의 결과가 더 좋고, language를 source로 활용했을 때, 가장 좋은 성능을 가졌다.

Ablation Studies

위의 여러가지 방법들로 성능 테스트를 해보았을 때, 이번 논문의 방법인 (a)와 (e)가 성능이 가장 좋았다.

특히 cyclic translation이 성능에 많은 영향을 끼치고 있다.

Conslusion

Seq2seq에 cyclic 특징을 넣었을 때 robust 하면서 좋은 성능을 이끌어 냈다. 다른 논문들은 80점의 score를 넘고 있지만 test를 할 때 text 하나만으로도 좋은 성능을 내는 것을 보아 연구할만한 가치가 있는 것 같다.