Does syntax matter? A strong baseline for Aspect-based Sentiment Analysis with RoBERTa

- Aspect-Based Sentiment Analysis (ABSA)는 Aspect의 특성을 예측하는 것이며, Sentiment Anaylsis의 한 분야다.

- 즉, 주어진 Aspect에 따라 sentiment를 예측하는 것('pos' or 'neg')

- 이전 연구에서는 Dependency Tree와 같은 syntactic information이 ABSA의 성능을 향상시키는 것을 보였음

- 최근에는 Pre-Trained Models(PTMs)도 ABSA에서 성능을 보이고 있다.

- 그러므로 PTM이 ABSA를 위해 충분한 syntactic 정보를 가지고 있어서, PTMs만을 기반으로 하여 좋은 ABSA 모델을 얻을 수 있는지 자연스러운 의문이 생긴다.

- 그래서 PTM에서 유도된 tree와 dependency parsing tree를 사용한 여러 유명한 모델을 비교해서 FT-RoBERTa로부터의 tree가 성능이 가장 좋음을 알 수 있다.

- 또한 FT-RoBERTa가 더 sentiment-word-oriented다.

- 순수한 RoBERTa 기반 모델도 충분한 SOTA 성능을 보인다.

1. Introduction

Aspect-Based Sentiment Analysis (ABSA)는 Aspect의 특성을 예측하는 것이며, Sentiment Anaylsis의 한 분야다.

- 한 문장에 여러 Aspect가 존재할 수 있고, 각 Aspect에 대해 sentiment를 예측해야 한다.

- "great food but the service was dreadful"과 같은 문장이 있다

- food와 service가 aspect가 되며, food의 sentiment는 'pos' service의 sentiment는 'neg'가 된다.

ABSA에는 Aspect Extraction(AE)와 Aspect-level sentiment classification(ALSC)가 있는데, 그 중 ALSC에 집중한다.

ALSC의 예전 연구들은 수동으로 설계된 syntactic feature에 의존했고 이는 굉장히 노동집약적이며 불충분하다

ALSC model 기반 dependency tree는 3가지 방법으로 적용된다.

Topological structure

Tree-based distance

1과 2를 동시에 사용

Dependency tree를 제외하고도 PTM이 좋은 성능을 기록했음

- PTM의 결과를 보면 dependency tree 정보를 함축적으로 담고 있다.

Q1: Will the tree induced from PTMs achieve better performance than the tree given by a dependency parser when combined with different tree-based ALSC models?

-> 뒷 부분에서 3개의 dependency tree와 파서가 제공하는 의존성 트리 및 PTM 유도 트리와 결합할 때 성능을 비교한다.

Q2: Will the tree induced from PTMs achieve better performance than the tree given by a dependency parser when combined with different tree-based ALSC models?

-> 이 논문에서 PTM으로부터의 tree도 사용하지만 FT-PTM으로부터의 tree도 사용한다. 실험결과를 보았을 때, FT-PTM이 더 좋은 성능을 기록했으며, dependency tree보다도 더 좋았다.

마지막으로 RoBERTa에 MLP만을 더해도 좋은 성능을 보였으며, tree 구조를 더하는 것은 큰 성과를 보이지 못했다.

기여점을 요약하면 다음과 같다.

(1) PTM, FT-PTM으로 유도된 트리를 비교해봄. FT-PTM으로부터의 tree가 가장 좋은 성능을 기록했으며, 다른 트리들보다도 좋았다.

(2) FT-PTM으로부터의 트리는 더 sentiment word oriented하다. 즉 aspect term과 sentiment adjective를 직접적으로 연결한다.

(3) RoBERTa를 사용했을 때 성능이 가장 좋게 나왔다.

2. Related Work

ALSC without Dependencies

LSTM, LSTM with attention, CNN등을 사용함

ALSC with Dependencies

초기에는 Sentiment lexicon과 parsing dependency를 결합해서 사용했음

이후에는 dependency tree와 neural network를 결합해서 사용하려는 시도가 있었음

- dependency tree를 binary tree로 바꾸는 것, 이후 recursive neural network를 젝용해 context word에서 aspect로 information을 전달하려는 시도를 함

- 별로 성능이 좋아지진 않음

- neural network

- GNN을 적용하려는 시도

- dependency tree를 aspect-oriented dependency tree

- Tree-based distance

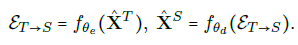

PTMs-based Dependency Probing

- PTMs는 NLP 분야에서 많이 사용되고 있다

- 그래서 PTMs으로 linguistic knowledge를 얻으려는 시도를 함

- 하나 혹은 여러개의 attention head를 사용해보았지만 dependency를 잡아내기 힘들었다

- 추가적인 파라미터를 사용해서 하려는 시도들이 있었음

3. Method

PTMs으로 부터 tree를 어떻게 유도하는지 알아보고, dependency tree를 통합하는 3가지 대표적인 방법에서 선택한 3개의 tree 기반 ASLC 모델들을 소개한다.

3.1 Inducing Tree Structure from PTMs

Perturbed Masking은 추가적인 parameter 없이 pre-trained model에서 tree를 유도할 수 있다.

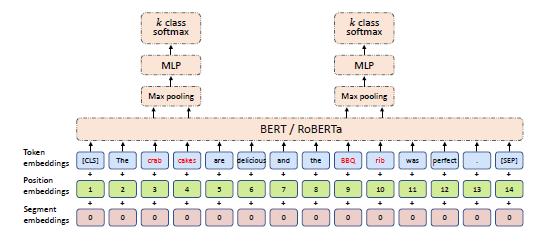

base가 되는 모델은 BERT와 RoBERTa를 사용하기 때문에, 이를 먼저 소개하고 Perturbed Masking을 소개한다.

3.1.1 BERT and RoBERTa

생략

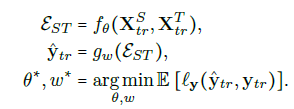

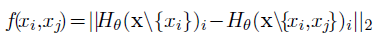

3.1.2 Perturbed Masking

Perturbed Masking은 pre-trained model로부터 syntactic 정보를 찾기 위한 것이 목적이다. BERT와 RoBERTa는 xi를 H(x)i에 map한다.

Perturbed Masking은 와 xj가 xi에 영향을 주는 정도인 f(xi,xj)를 유도하는 것이 목적이다.

우선 [MASK]를 사용해서 xi를 대체하고 H(x\{xi})i를 반환한다.

그 다음으론 xj를 mask를 하고 H(x\{xi,xj})i 를 얻고 f는 다음과 같이 구한다.

이 과정을 문장의 매 두 토큰에 대해 수행하면 f값들로 이루어진 M을 얻을 수 있다.

tree decoding 알고리즘을 통해서 M으로 부터 dependency tree를 얻는다.

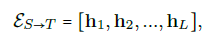

3.2 ALSC Models Based on Trees

3개의 representative tree 기반 ALSC model을 소개함 각 모델들은 introduction에서 소개했고, 공정한 비교를 위해 가장 최근에 발전된 ALSC 모델들을 선정함

3.2.1 Aspect-specific Graph Convolutional Networks(ASGCN)

dependency tree를 그래프로 이용함. word를 노드로, dependency를 edge로 사용

3.2.2 Proximity-Weighted Convolution Network(PWCN)

PWCN은 aspect가 contextual word를 찾을수 있도록 도운다. input sentence에서 PWCN은 dependency tree를 얻고, 이 트리를 기반해서 각 단어에 proximity value를 부여한다.

각 단어의 proximity value는 단어와 aspect 사시의 dependency tree의 짧은 path를 계산하여 얻는다.

3.3 Relation Graph Attention Network

dependency tree를 aspect-oriented dependency tree로 변환한다.

aspect-oriented dependency tree는 aspect를 root로 사용하고, 다른 단어들은 leaf가 되는 구조

aspect와 다른 단어사이의 관계는 syntactic tag나 tree 기반 거리를 기반으로 구한다.

4. Experimental Setup

4가지 언어로 구성되어 있는 6개 데이터셋에 대해서 실험을 진행함

4.1 Datasets

pass

4.2 Tree Strucutres

(1) spaCy나 allenNLP에서 얻은 dependency tree parer로부터의 tree -> "Dep"

(2)PTM으로 얻은 tree

(3)Perturbed Masking을 사용한 FT-PTM

(4) Left, Right chain -> 왼쪽이나 오른쪽 단어에 의존하는 방법

4.3 Implementation Details

5. Experimental Results

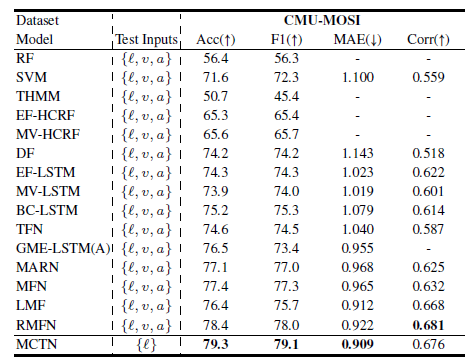

5.1 ALSC Performance with Different Trees

다른 트리를 가지고 있는 모델 간의 비교는 위와 같다.

FT-RoBERTa induced Tree를 사용할 때, 가장 좋은 성능을 기록함

BERT Induced Tree나 RoBERTa Induced Tree를 기반으로 한 모델들은 Left-chain이나 Right chain이나 큰 차이가 없음

- RoBERTa의 연결성을 보면 주위에 강하게 연결되어 있는데, 그 이유는 MLM을 수행하는 과정에서 주변을 많이 봐야하기 때문 그래서 왼쪽 종속이나 오른쪽에 종속하는 것과 큰차이가 없다

Q1에 대한 답변을 하자면 "Dep"이 BERT Induced Tree나 RoBERTa Induced Tree보다 더 좋음

- 그 이유는 PTM은 왼쪽이나 오른쪽에 의존하기 때문에

- PWCN의 경우에만 더 좋은 성능을 보였는데 그건 크게 문제 될 것은 없음

- 하지만 FT-PTM은 dependency tree보다 더 좋음

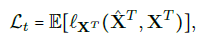

5.2 Analysis

- tree간의 차이를 조사하기 위해 quantitaive metrics를 제안함

Proportion of Neighboring Connections

위 표는 문장에서 주위 단어와 연결되어 있는 비율을 뜻함

BERT가 70퍼대의 연결성을 보이는데 이 것이 성능에 영향을 줬을 것

FT-PTM일땐 충분한 하락을 보임

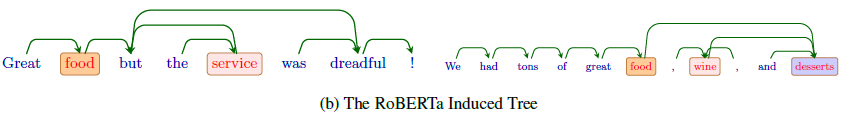

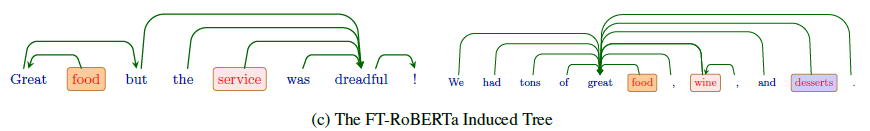

그림으로 보면 다음과 같음

Aspects-sentiment Distance

Aspect와 sentiment word 사이의 평균 거리를 의미

- C는 pre-define sentiment words set

- Amazon-2

- S는 dataset, Si는 sentence, Si는 w들로 구성되어 있음

- |.|은 set의 원소 갯수

- FTM-PTM의 거리가 가장 짧다

첫 표의 "Dep" 결과를 볼 때 Twitter만 결과가 조금 다른데, 이는 Twitter가 문법을 중시하지 않기 때문에 그럼

Q2에 대한 답을 해보자면 PNC가 줄었기 때문에 긴 연결이 생겼지만 AsD를 보면 그 거리가 짧기 때문에 문제가 없다.

따라서 FT-PTM은 ALSC task에 적합하며 성능도 더 좋다.

5.3 Comparision between ALSC models

- MLP와 RoBERTa를 사용했어도 SOTA에 근접한 성능을 나타낸다.

- FT-RoBERTa는 Glove 기반의 모델에 효과적이며, RoBERTa와 결합하는 것은 큰 효과는 없다. 오히려 감소한 케이스가 있을 정도

- RoBERTa 기반 ALSC 모델을 최적화하는 것은 어려움

6. Conclusion

- parser-provided dependency tree와 PTMs 기반 tree를 포함한 여러 트리들을 비교함

- 특히 Perturbed Masking을 사용한 PTM 방법이 가장 성능이 좋았음

- Glove 기반 모델에 더 좋은 성능 향상을 보이며, RoBERTa+MLP로만 사용해도 성능이 좋다.